新增文章

@ -113,7 +113,7 @@ theme: butterfly

|

||||

## Docs: https://hexo.io/docs/one-command-deployment

|

||||

deploy:

|

||||

type: git

|

||||

repo: https://gogs.zyjblogs.cn/zhuyijun/hexo.zyjblogs.cn.git

|

||||

repo: git@gogs.zyjblogs.cn:zhuyijun/hexo.zyjblogs.cn.git

|

||||

branch: master

|

||||

|

||||

bangumi:

|

||||

|

||||

5793

package-lock.json

generated

Normal file

@ -3,7 +3,7 @@

|

||||

"version": "0.0.0",

|

||||

"private": true,

|

||||

"scripts": {

|

||||

"build": "hexo generate",

|

||||

"build": "hexo clean && hexo bangumi -u && hexo generate",

|

||||

"clean": "hexo clean",

|

||||

"deploy": "hexo deploy",

|

||||

"server": "hexo server"

|

||||

|

||||

156

source/_posts/algorithm/backtracking/nqueens/NQueens.md

Normal file

@ -0,0 +1,156 @@

|

||||

---

|

||||

title: N皇后

|

||||

date: 2024-3-19

|

||||

tag:

|

||||

- 算法

|

||||

- 回溯

|

||||

- 递归

|

||||

categories: 算法

|

||||

abbrlink: bd497d25

|

||||

---

|

||||

|

||||

# N皇后

|

||||

[51. N皇后](https://leetcode-cn.com/problems/n-queens/)

|

||||

### 题目描述

|

||||

> n 皇后问题研究的是如何将 n 个皇后放置在 n×n 的棋盘上,并且使皇后彼此之间不能相互攻击。

|

||||

>

|

||||

|

||||

>

|

||||

上图为 8 皇后问题的一种解法。

|

||||

>

|

||||

给定一个整数 n,返回所有不同的 n 皇后问题的解决方案。

|

||||

>

|

||||

每一种解法包含一个明确的 n 皇后问题的棋子放置方案,该方案中 'Q' 和 '.' 分别代表了皇后和空位。

|

||||

|

||||

示例:

|

||||

|

||||

```

|

||||

输入: 4

|

||||

输出: [

|

||||

[".Q..", // 解法 1

|

||||

"...Q",

|

||||

"Q...",

|

||||

"..Q."],

|

||||

|

||||

["..Q.", // 解法 2

|

||||

"Q...",

|

||||

"...Q",

|

||||

".Q.."]

|

||||

]

|

||||

解释: 4 皇后问题存在两个不同的解法。

|

||||

```

|

||||

|

||||

### 问题分析

|

||||

约束条件为每个棋子所在的行、列、对角线都不能有另一个棋子。

|

||||

|

||||

使用一维数组表示一种解法,下标(index)表示行,值(value)表示该行的Q(皇后)在哪一列。

|

||||

每行只存储一个元素,然后递归到下一行,这样就不用判断行了,只需要判断列和对角线。

|

||||

### Solution1

|

||||

当result[row] = column时,即row行的棋子在column列。

|

||||

|

||||

对于[0, row-1]的任意一行(i 行),若 row 行的棋子和 i 行的棋子在同一列,则有result[i] == column;

|

||||

若 row 行的棋子和 i 行的棋子在同一对角线,等腰直角三角形两直角边相等,即 row - i == Math.abs(result[i] - column)

|

||||

|

||||

布尔类型变量 isValid 的作用是剪枝,减少不必要的递归。

|

||||

```java

|

||||

public List<List<String>> solveNQueens(int n) {

|

||||

// 下标代表行,值代表列。如result[0] = 3 表示第1行的Q在第3列

|

||||

int[] result = new int[n];

|

||||

List<List<String>> resultList = new LinkedList<>();

|

||||

dfs(resultList, result, 0, n);

|

||||

return resultList;

|

||||

}

|

||||

|

||||

void dfs(List<List<String>> resultList, int[] result, int row, int n) {

|

||||

// 递归终止条件

|

||||

if (row == n) {

|

||||

List<String> list = new LinkedList<>();

|

||||

for (int x = 0; x < n; ++x) {

|

||||

StringBuilder sb = new StringBuilder();

|

||||

for (int y = 0; y < n; ++y)

|

||||

sb.append(result[x] == y ? "Q" : ".");

|

||||

list.add(sb.toString());

|

||||

}

|

||||

resultList.add(list);

|

||||

return;

|

||||

}

|

||||

for (int column = 0; column < n; ++column) {

|

||||

boolean isValid = true;

|

||||

result[row] = column;

|

||||

/*

|

||||

* 逐行往下考察每一行。同列,result[i] == column

|

||||

* 同对角线,row - i == Math.abs(result[i] - column)

|

||||

*/

|

||||

for (int i = row - 1; i >= 0; --i) {

|

||||

if (result[i] == column || row - i == Math.abs(result[i] - column)) {

|

||||

isValid = false;

|

||||

break;

|

||||

}

|

||||

}

|

||||

if (isValid) dfs(resultList, result, row + 1, n);

|

||||

}

|

||||

}

|

||||

```

|

||||

### Solution2

|

||||

使用LinkedList表示一种解法,下标(index)表示行,值(value)表示该行的Q(皇后)在哪一列。

|

||||

|

||||

解法二和解法一的不同在于,相同列以及相同对角线的校验。

|

||||

将对角线抽象成【一次函数】这个简单的数学模型,根据一次函数的截距是常量这一特性进行校验。

|

||||

|

||||

这里,我将右上-左下对角线,简称为“\”对角线;左上-右下对角线简称为“/”对角线。

|

||||

|

||||

“/”对角线斜率为1,对应方程为y = x + b,其中b为截距。

|

||||

对于线上任意一点,均有y - x = b,即row - i = b;

|

||||

定义一个布尔类型数组anti_diag,将b作为下标,当anti_diag[b] = true时,表示相应对角线上已经放置棋子。

|

||||

但row - i有可能为负数,负数不能作为数组下标,row - i 的最小值为-n(当row = 0,i = n时),可以加上n作为数组下标,即将row -i + n 作为数组下标。

|

||||

row - i + n 的最大值为 2n(当row = n,i = 0时),故anti_diag的容量设置为 2n 即可。

|

||||

|

||||

|

||||

|

||||

“\”对角线斜率为-1,对应方程为y = -x + b,其中b为截距。

|

||||

对于线上任意一点,均有y + x = b,即row + i = b;

|

||||

同理,定义数组main_diag,将b作为下标,当main_diag[row + i] = true时,表示相应对角线上已经放置棋子。

|

||||

|

||||

有了两个校验对角线的数组,再来定义一个用于校验列的数组cols,这个太简单啦,不解释。

|

||||

|

||||

**解法二时间复杂度为O(n!),在校验相同列和相同对角线时,引入三个布尔类型数组进行判断。相比解法一,少了一层循环,用空间换时间。**

|

||||

|

||||

```java

|

||||

List<List<String>> resultList = new LinkedList<>();

|

||||

|

||||

public List<List<String>> solveNQueens(int n) {

|

||||

boolean[] cols = new boolean[n];

|

||||

boolean[] main_diag = new boolean[2 * n];

|

||||

boolean[] anti_diag = new boolean[2 * n];

|

||||

LinkedList<Integer> result = new LinkedList<>();

|

||||

dfs(result, 0, cols, main_diag, anti_diag, n);

|

||||

return resultList;

|

||||

}

|

||||

|

||||

void dfs(LinkedList<Integer> result, int row, boolean[] cols, boolean[] main_diag, boolean[] anti_diag, int n) {

|

||||

if (row == n) {

|

||||

List<String> list = new LinkedList<>();

|

||||

for (int x = 0; x < n; ++x) {

|

||||

StringBuilder sb = new StringBuilder();

|

||||

for (int y = 0; y < n; ++y)

|

||||

sb.append(result.get(x) == y ? "Q" : ".");

|

||||

list.add(sb.toString());

|

||||

}

|

||||

resultList.add(list);

|

||||

return;

|

||||

}

|

||||

for (int i = 0; i < n; ++i) {

|

||||

if (cols[i] || main_diag[row + i] || anti_diag[row - i + n])

|

||||

continue;

|

||||

result.add(i);

|

||||

cols[i] = true;

|

||||

main_diag[row + i] = true;

|

||||

anti_diag[row - i + n] = true;

|

||||

dfs(result, row + 1, cols, main_diag, anti_diag, n);

|

||||

result.removeLast();

|

||||

cols[i] = false;

|

||||

main_diag[row + i] = false;

|

||||

anti_diag[row - i + n] = false;

|

||||

}

|

||||

}

|

||||

```

|

||||

88

source/_posts/algorithm/dp/ways/状态转移方程.md

Normal file

@ -0,0 +1,88 @@

|

||||

---

|

||||

title: 状态转移方程

|

||||

date: 2024-3-19

|

||||

tag:

|

||||

- dp

|

||||

categories:

|

||||

- 算法

|

||||

abbrlink: 92fa7813

|

||||

---

|

||||

|

||||

# 状态转移方程

|

||||

|

||||

## **定义**

|

||||

|

||||

[动态规划](https://baike.so.com/doc/6995222-7218096.html)中本阶段的状态往往是上一阶段状态和上一阶段决策的结果。若给定了第K阶段的状态Sk以及决策uk(Sk),则第K+1阶段的状态Sk+1也就完全确定。也就是说Sk+1与Sk,uk之间存在一种明确的数量对应关系,记为Tk(Sk,uk),即有Sk+1= Tk(Sk,uk)。 这种用函数表示前后阶段关系的方程,称为状态转移方程。在上例中状态转移方程为 Sk+1= uk(Sk) 。

|

||||

|

||||

## **设计**

|

||||

|

||||

适用条件

|

||||

|

||||

任何思想方法都有一定的局限性,超出了特定条件,它就失去了作用。同样,动态规划也并不是万能的。适用动态规划的问题必须满足最优化原理和无后效性。

|

||||

|

||||

1.[最优化原理](https://baike.so.com/doc/1852557-1959037.html)(最优子结构性质) 最优化原理可这样阐述:一个最优化策略具有这样的性质,不论过去状态和决策如何,对前面的决策所形成的状态而言,余下的诸决策必须构成最优策略。简而言之,一个最优化策略的子策略总是最优的。一个问题满足最优化原理又称其具有最优子结构性质。

|

||||

|

||||

2.无后效性将各阶段按照一定的次序排列好之后,对于某个给定的阶段状态,它以前各阶段的状态无法直接影响它未来的决策,而只能通过当前的这个状态。换句话说,每个状态都是过去历史的一个完整总结。这就是无后向性,又称为无后效性。

|

||||

|

||||

3.子问题的重叠性 动态规划将原来具有指数级时间复杂度的[搜索算法](https://baike.so.com/doc/6058609-6271658.html)改进成了具有多项式时间复杂度的算法。其中的关键在于解决冗余,这是动态规划算法的根本目的。动态规划实质上是一种以空间换时间的技术,它在实现的过程中,不得不存储产生过程中的各种状态,所以它的空间复杂度要大于其它的算法。

|

||||

|

||||

如何设计动态转移方程

|

||||

|

||||

如果满足上述条件,一般可以按照以下步骤进行设计:

|

||||

|

||||

一、确定问题的[决策对象](https://baike.so.com/doc/8780581-9104627.html)

|

||||

|

||||

二、对决策对象划分阶段

|

||||

|

||||

三、对各阶段确定[状态变量](https://baike.so.com/doc/1032672-1092144.html)

|

||||

|

||||

四、根据状态变量确定费用函数和目标函数

|

||||

|

||||

五、建立各阶段的状态变量的转移方程,写出状态转移方程

|

||||

|

||||

六、编程实现

|

||||

|

||||

## **状态转移方程的代码实现**

|

||||

|

||||

假设列出了状态转移方程:d(i, j) = a(i, j) + max{d(i + 1, j), d(i + 1, j + 1)}。

|

||||

|

||||

### [折叠](https://baike.so.com/doc/2649061-2797348.html#)**递归计算**

|

||||

|

||||

```cpp

|

||||

int d(int i, int j){

|

||||

return a[i][j] + (i == n ? 0 : (d(i + 1, j) > d(i + 1, j + 1) ? d(i + 1, j) : d(i + 1, j + 1)));

|

||||

}

|

||||

```

|

||||

|

||||

|

||||

|

||||

递归方法的缺点是:效率比较低,首先在调用函数的嵌套时,函数不断的切换,由此降低了效率。其次是相同的子问题被重复求解,例如:d(2, 3), d(4, 2), d(4, 3)就是被重复求解了两次。

|

||||

|

||||

### [折叠](https://baike.so.com/doc/2649061-2797348.html#)**递推计算**

|

||||

|

||||

```cpp

|

||||

int i, j;

|

||||

for(j = 1; j <= n; ++j)

|

||||

d[n][j] = a[n][j];

|

||||

for(i = n-1; i >= 1; --i)

|

||||

for(j = 1; j <= i; ++j)

|

||||

d[i][j] = a[i][j] + (d[i + 1][j] > d[i + 1][j + 1] ? d[i + 1][j] : d[i + 1][j + 1]);

|

||||

```

|

||||

|

||||

递推要注意边界的处理。

|

||||

|

||||

### [折叠](https://baike.so.com/doc/2649061-2797348.html#)**记忆化搜索**

|

||||

|

||||

首先设置一个数组,目的是保存已经计算好的子问题的解,下次再计算相同子问题时,就不用重复求解了,如下设置一个st数组用来保存计算好的子问题的解,初始化st所有元素为-1。

|

||||

|

||||

```cpp

|

||||

int d(int i, int j){

|

||||

if(st[i][j] > 0)

|

||||

return st[i][j];

|

||||

return st[i][j] = a[i][j] + (i == n ? 0 : (d(i + 1, j) > d(i + 1, j + 1) ? d(i + 1, j) : d(i + 1, j + 1)));

|

||||

}

|

||||

```

|

||||

|

||||

记忆化搜索用的也是递归的方法,目的是把子问题的解保存下来,避免重复计算的情况,这是它比纯递归更高效的原因。

|

||||

|

||||

记忆化搜索跟递推相比,它的优点是:它不必事先确定好各状态的计算顺序,但使用递推时必须事先确定好计算顺序。

|

||||

269

source/_posts/algorithm/graph/serach/寻路算法之AStar算法原理及实现.md

Normal file

@ -0,0 +1,269 @@

|

||||

---

|

||||

title: 「游戏」寻路算法之A Star算法原理及实现

|

||||

date: 2024-3-19

|

||||

tag:

|

||||

- 图

|

||||

categories: 算法

|

||||

abbrlink: '0'

|

||||

---

|

||||

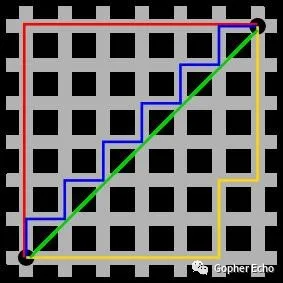

## 「游戏」寻路算法之A Star算法原理及实现

|

||||

|

||||

## 前言

|

||||

|

||||

自动寻路是在一些如MMORPG等类型游戏中常见的一种功能,其给了玩家良好的游戏体验,使得玩家在游戏过程中省去了大量游戏坐标点的记录以及长时间的键盘操作,不必记忆坐标,不必担心迷路,用最快捷的方法移动到指定地点。

|

||||

|

||||

寻路算法(自动寻路算法,下同),其实可以看作是一种路径查找算法以及图搜索算法,图搜索(Graph Search)算法是用于在图上进行一般性发现或显式地搜索的算法。这些算法在图上找到出路径,但没有期望这些路径是在计算意义上是最优的。

|

||||

|

||||

路径查找算法(Pathfinding)是建立在图搜索算法的基础上,它探索节点之间的路径,从一个节点开始,遍历关系,直到到达目的节点。这些算法用于识别图中的最优路由,算法可以用于诸如物流规划、最低成本呼叫或IP路由以及游戏模拟等用途。

|

||||

|

||||

常见的路径搜索算法和图搜索算法有:A*(A Star)算法、Dijkstra算法、广(深)度优先搜索、最佳优先搜索、Jump Point Search算法等,今天本文主要讲解的是A*(A Star)算法的原理以及实现。

|

||||

|

||||

## 常见搜索算法

|

||||

|

||||

### Dijkstra算法

|

||||

|

||||

迪杰斯特拉算法(Dijkstra)是由荷兰计算机科学家狄克斯特拉于1959 年提出的,因此又叫狄克斯特拉算法。是从一个顶点到其余各顶点的最短路径算法,解决的是有权图中最短路径问题。迪杰斯特拉算法主要特点是从起始点开始,采用贪心算法的策略,每次遍历到始点距离最近且未访问过的顶点的邻接节点,直到扩展到终点为止[^1]。

|

||||

|

||||

在游戏中(仅以2D为例),我们把某个场景的地图按照一定的规则划分成一个个的小格子,每个格子代表一个可用的坐标点,该坐标点有两种状态分别为:有效、无效。其中有效状态代表为该坐标点玩家可以正常通过,无效为该坐标点玩家无法到达,即当前坐标点可能存在阻挡物,如河流、山川、npc等,并且,以每个格子(以正方形为例)为中心可以分别向8个不同方向前进,在像每个方向前进时,所需的代价是不同的。

|

||||

|

||||

> 举个例子(后续的所有移动代价皆以此计算)

|

||||

>

|

||||

> 当玩家向自身8个方向中的横轴以及纵轴进行移动时(即向上、下、左、右),移动代价为10(别问为啥为10,拍脑门决定的)。

|

||||

>

|

||||

> 当玩家向自身八个方向中的对角方向进行移动时(即左上、左下、右上、右下),移动代价为横(纵)轴移动的1.4倍(因为正方形的对角线是边长约1.4倍)。

|

||||

|

||||

在使用该算法的时候需要选择一个周围8方向中,距离起点总移动代价最低的节点作为下一个要遍历的节点,一直到当前节点为终点或者无可用节点为止。那么此时就需要一个优先队列来保存当前节点的8方向中的可用节点、以方便的查找到移动代价最低的节点。

|

||||

|

||||

|

||||

|

||||

> 左图为BFS算法右图为Dijkstra算法(图侵删)

|

||||

>

|

||||

> 上图对比了不考虑节点移动代价差异的广度优先搜索与考虑移动代价的Dijkstra算法的运行图

|

||||

|

||||

应当注意,绝大多数的戴克斯特拉算法不能有效处理移动代价为负的图[^2]。

|

||||

|

||||

### 最佳优先搜索算法(Best-First-Search)

|

||||

|

||||

最佳优先搜索算法是一种启发式搜索算法(Heuristic Algorithm),其基于广度优先搜索算法,不同点是其依赖于估价函数对将要遍历的节点进行估价,选择代价小的节点进行遍历,直到找到目标点为止。BFS算法不能保证找到的路径是一条最短路径,但是其计算过程相对于Dijkstra算法会快很多[^3]。

|

||||

|

||||

所谓的启发式搜索算法,就是针对游戏地图中的每一个位置节点进行评估,从而得到相对来说最优的位置,而后再从这个最优为止再次进行搜索,直到符合终止条件或者超出地图范围为止,这样可以省略大量无谓的搜索路径,提高了效率。在启发式搜索中,对位置的预估是十分重要的。因此就需要使用启发函数来进行位置预估。

|

||||

|

||||

这个算法和Dijkstra算法差不多,同样也使用一个优先队列,但此时以每个节点的移动代价作为优先级去比较,每次都选取移动代价最小的,因为此时距离终点越来越近,所以说这种算法称之为最佳优先(Best First)算法。

|

||||

|

||||

接下来看一下运行事例:

|

||||

|

||||

|

||||

|

||||

> 图侵删

|

||||

>

|

||||

> 左侧为Dijkstra算法右侧为最佳优先搜索算法

|

||||

|

||||

最佳优先搜索算法相对于Dijkstra算法的问题在哪里呢?看一下中途有阻挡的时候的情况:

|

||||

|

||||

|

||||

|

||||

> 图侵删

|

||||

>

|

||||

> 左侧为Dijkstra算法右侧为最佳优先搜索算法

|

||||

|

||||

从上图中可以看出,当地图中存在障碍物的时候,最佳优先搜索算法并不能找到最短路径。

|

||||

|

||||

### A Star 算法

|

||||

|

||||

A Star算法是一种在游戏开发过程中很常用的自动寻路算法。它有较好的性能和准确度。**A\*搜索算法**(A* search algorithm)是一种在图形平面上,有多个节点的路径,求出最低通过成本的算法。常用于游戏中的NPC的移动计算,或网络游戏的BOT的移动计算上。该算法综合了最佳优先搜索和Dijkstra算法的优点:在进行启发式搜索提高算法效率的同时,可以保证找到一条基于启发函数的最优路径[^4]。

|

||||

|

||||

### 启发公式

|

||||

|

||||

A Star算法也是一种启发式搜索算法那么其与最佳优先搜索算法一样需要一个启发函数左右计算移动代价的方法,那么A Star的启发函数公式为:$$ f(n) = g(n)+h(n) $$

|

||||

|

||||

解释下这个公式的各项的含义:

|

||||

|

||||

•**h(n)**:从当前节点n到终点的预估的代价。•**g(n)**:从起始点到达当前节点n的代价。•**f(n)**:为当前节点n的综合的代价,在选择下一个节点的时候,其值越低,优先级就越高(因为代价小)。

|

||||

|

||||

关于启发函数中*h(n)**公式的的选择,由于游戏地图中大部分都是被分为网格形式(即整个地图被拆分为多个正方形格子),那么此时就有3种可选的启发函数的**h(n)*公式可用,分别为:

|

||||

|

||||

> 曼哈顿距离:出租车几何或曼哈顿距离(Manhattan Distance)是由十九世纪的赫尔曼·闵可夫斯基所创词汇,是种使用在几何度量空间的几何学用语,用以标明两个点在标准坐标系上的绝对轴距总和。

|

||||

>

|

||||

>

|

||||

>

|

||||

> 曼哈顿距离一般用在在移动时,只允许朝上下左右四个方向移动的情况下使用。

|

||||

>

|

||||

> 在平面中X1点到X2点的距离为其公式为:$$ d(i,j)=|X1-X2|+|Y1-Y2| $$ 转换为程序语言如下,其中Cost为相邻两个节点移动所耗费的代价

|

||||

>

|

||||

> ```

|

||||

> func Manhattan(startX, startY, endX, endY float64) float64 {

|

||||

> dx := math.Abs(startX - endX)

|

||||

> dy := math.Abs(startY - endY)

|

||||

> return Cost * (dx + dy)

|

||||

> }

|

||||

> ```

|

||||

|

||||

> 对角线距离:如果你的地图允许对角线运动,则启发函数可以使用对角距离。它的计算方法如下:

|

||||

>

|

||||

> 其中HVCost是水平、垂直方向移动代价,SCost为倾斜方向移动代价

|

||||

>

|

||||

> ```

|

||||

> func Diagonal(startX, startY, endX, endY float64) float64 {

|

||||

> dx := math.Abs(startX - endX)

|

||||

> dy := math.Abs(startY - endY)

|

||||

> return HVCost*(dx+dy) + (SCost-2*HVCost)* math.Min(dx, dy)

|

||||

> }

|

||||

> ```

|

||||

|

||||

> 欧几里得距离:是一个通常采用的距离定义,指在m维空间中两个点之间的真实距离,或者向量的自然长度(即该点到原点的距离),其公式为:$$ \sqrt[2]{ (x2−x1)^2+(y2−y1)^2} $$

|

||||

>

|

||||

> 该公式为点(x1,y1)与点(x2,y2)之间的欧氏距离

|

||||

>

|

||||

> ```

|

||||

> func Euclidean(startX, startY, endX, endY float64) float64 {

|

||||

> dx := math.Abs(startX - endX)

|

||||

> dy := math.Abs(startY - endY)

|

||||

> return D * math.Sqrt(dx * dx + dy * dy)

|

||||

> }

|

||||

> ```

|

||||

|

||||

在此文章中我们选择对角距离公式来作为启发函数求*h(n)*的公式。

|

||||

|

||||

启发函数可能对算法造成的影响[^5]:

|

||||

|

||||

•在极端情况下,当启发函数h(n) 始终为0,则将由g(n) 决定节点的优先级,此时算法就退化成了Dijkstra算法。•如果h(n) 始终小于等于节点n到终点的代价,则A*算法保证一定能够找到最短路径。但是当h(n)的值越小,算法将遍历越多的节点,也就导致算法越慢。•如果h(n) 完全等于节点n到终点的代价,则A*算法将找到最佳路径,并且速度很快。可惜的是,并非所有场景下都能做到这一点。因为在没有达到终点之前,我们很难确切算出距离终点还有多远。•如果h(n)的值比节点n到终点的代价要大,则A*算法不能保证找到最短路径,不过此时会很快。•在另外一个极端情况下,如果h(n)相较于g(n)大很多,则此时只有h(n)产生效果,这也就变成了最佳优先搜索。

|

||||

|

||||

### A Star算法执行过程

|

||||

|

||||

在搜索过程中,A Star算法需要遍历周围8方向的8个节点,并将之有效的节点(即可通过的节点)计算**f(n)\**后放入一个优先级队列中,以便下次循环可以直接取出优先级最高的节点继续遍历,此时我们把这个优先级队列称呼为\*\**\*OpenList\****,另外A Star算法中也需要一个容器用来存储已经遍历过的节点、以防止重复的遍历,那么此时我们把这个容器称之为****CloseList\****。

|

||||

|

||||

接下来本文讲按照步骤说明A Star算法每一步的执行过程:

|

||||

|

||||

1.对***OpenList\**\**和\****CloseList***进行初始化,作者采用小根堆来作为\**\**OpenList\****的实现数据结构,采用HashMap作为****CloseList\****的数据结构,其中Key为节点坐标值Value为空结构体。2.首先确定Start节点以及End节点,而后将Start节点放入****OpenList\****中。3.从****OpenList\****中取出一个节点Cur,如果Cur节点为End节点,则回溯当前节点结构中存储的父节点对象(像链表一样向前回溯)直到父节点对象为nil或者为Start节点,此时得到搜索到的路径,搜索结束返回。4.如果Cur节点非End节点则进行如下逻辑:

|

||||

|

||||

1.将当前X节点放入***CloseList\**\**中,如果在取出Cur节点时未做删除操作的话那么则从\****OpenList***中删除。2.遍历Cur节点其周围8方向的所有额邻居可用节点、可用节点的条件为:

|

||||

|

||||

1.是可通过的节点。2.未处于****CloseList\****中。

|

||||

|

||||

3.计算当前的Cur节点的邻居可用节点,计算其**f(n)\**值,设置其父节点为Cur节点,随后将其加入至\*\**\*OpenList\****中。

|

||||

|

||||

|

||||

|

||||

5.循环执行3-4。直到找不到有效路径或找到End节点。

|

||||

|

||||

|

||||

|

||||

### 代码实现

|

||||

|

||||

本章代码采用Go1.16.2版本实现,主要展示的是搜索业务逻辑部分的代码。

|

||||

|

||||

```

|

||||

// 优先队列

|

||||

type PriorityQueue []*Node

|

||||

|

||||

func (receiver PriorityQueue) Len() int {

|

||||

return len(receiver)

|

||||

}

|

||||

|

||||

func (receiver PriorityQueue) Less(i, j int) bool {

|

||||

return receiver[i].Fn() < receiver[j].Fn()

|

||||

}

|

||||

|

||||

func (receiver PriorityQueue) Swap(i, j int) {

|

||||

receiver[i], receiver[j] = receiver[j], receiver[i]

|

||||

}

|

||||

|

||||

func (receiver *PriorityQueue) Push(x interface{}) {

|

||||

*receiver = append(*receiver, x.(*Node))

|

||||

}

|

||||

|

||||

func (receiver *PriorityQueue) Pop() interface{} {

|

||||

index := len(*receiver)

|

||||

v := (*receiver)[index-1]

|

||||

*receiver = (*receiver)[:index-1]

|

||||

return v

|

||||

}

|

||||

|

||||

// 传入的是一个存放搜索路径的切片

|

||||

// *tools.Node 是节点指针

|

||||

func (receiver *FindAWay) doAStar(result *[]*tools.Node) {

|

||||

for receiver.OpenQueue.Len() > 0 {

|

||||

// 从 OpenList 里取出一个节点

|

||||

node := receiver.openGet()

|

||||

// 看看是不是终点

|

||||

if receiver.end.Equal(node.Position()) {

|

||||

receiver.statistics(node, result)

|

||||

return

|

||||

}

|

||||

// 节点放入CloseList

|

||||

receiver.closePut(node)

|

||||

// 进行具体处理

|

||||

receiver.azimuthProcessing(node)

|

||||

}

|

||||

}

|

||||

|

||||

func (receiver *FindAWay) azimuthProcessing(node *tools.Node) {

|

||||

// 遍历当前节点的8个方向

|

||||

// tools.NodeFormula 是一个存有 计算8个方向坐标的函数数组

|

||||

for azimuth, f := range tools.NodeFormula {

|

||||

// Position 返回一个 存放了 XY字段的结构体代表节点坐标

|

||||

nearNode := tools.GlobalMap.GetNode(f(node.Position()))

|

||||

// 返回为nil代表节点超出边界

|

||||

// EffectiveCoordinate() 代表当前邻居节点是否可用,即是否可以通过

|

||||

if nearNode == nil || !nearNode.EffectiveCoordinate() {

|

||||

continue

|

||||

}

|

||||

// 查看当前邻居节点是否处于 CloseList里

|

||||

if _, ok := receiver.CloseMap[nearNode.Position()]; ok {

|

||||

continue

|

||||

}

|

||||

// 查看当前邻居节点是否处于 OpenList里

|

||||

// 这算是个优化,防止OpenList插入重复节点

|

||||

if _, ok := receiver.OpenMap[nearNode.Position()]; !ok {

|

||||

// 设置当前邻居节点的父节点为当前节点

|

||||

nearNode.SetParent(node)

|

||||

// 根据所处方位使用不同的移动代价计算Fn值

|

||||

|

||||

// 此时 HVCost =10

|

||||

// SCost = HVCost * 1.4

|

||||

switch tools.Azimuth(azimuth) {

|

||||

// 斜方计算

|

||||

case tools.LeftUp, tools.LeftDown, tools.RightUp, tools.RightDown:

|

||||

nearNode.CalcGn(tools.SCost).CalcHn(receiver.end.Position()).CalcFn()

|

||||

// 垂直、水平方向计算

|

||||

default:

|

||||

nearNode.CalcGn(tools.HVCost).CalcHn(receiver.end.Position()).CalcFn()

|

||||

}

|

||||

// 将当前邻居节点放入OpenList中

|

||||

receiver.openPut(nearNode)

|

||||

}

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

### 结果测试

|

||||

|

||||

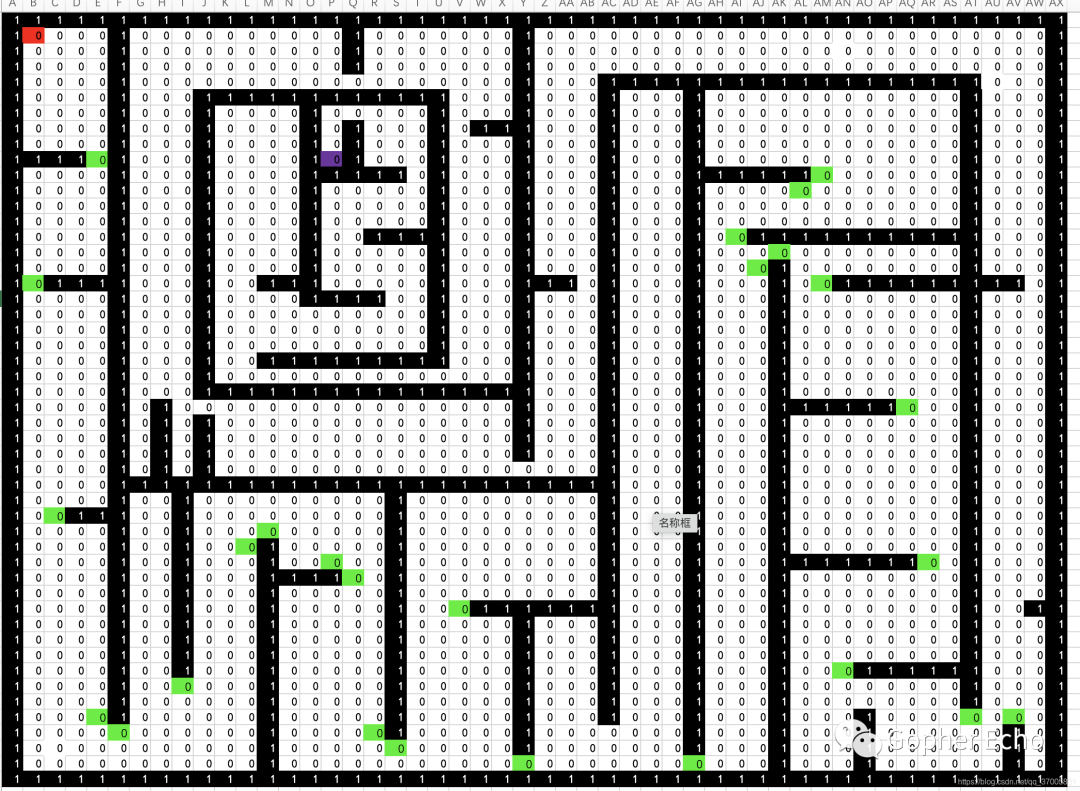

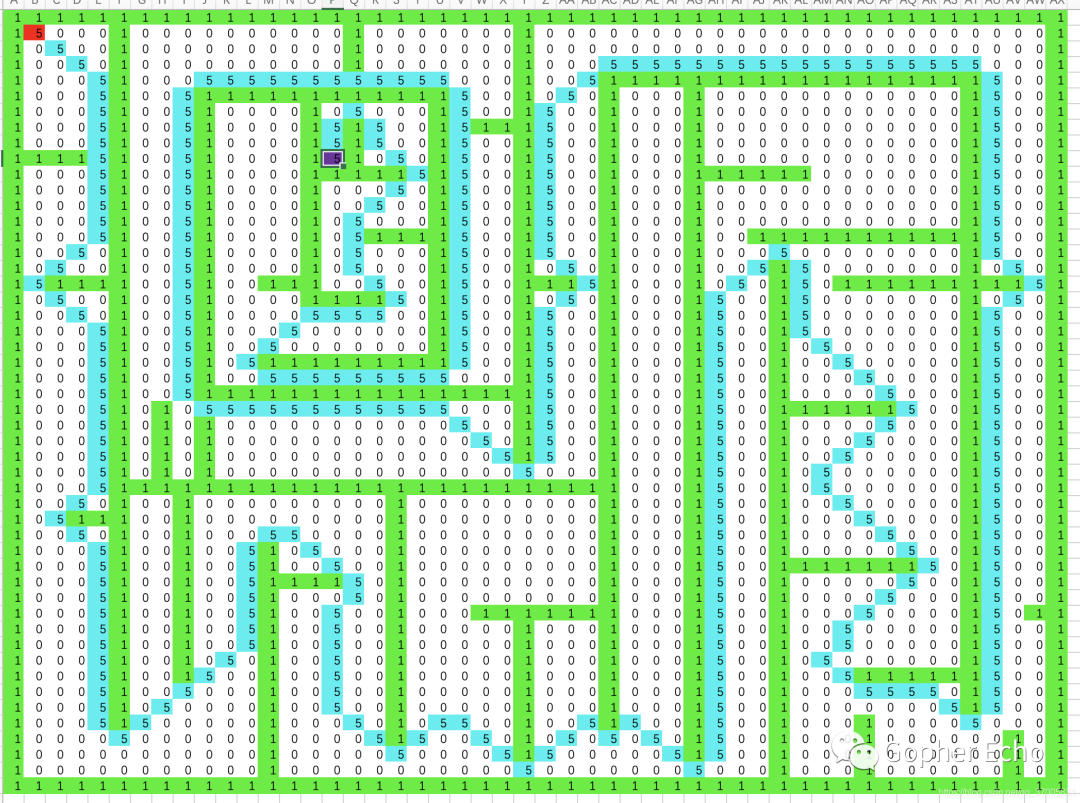

由于没有找到比较方便的实时现实库,所以就拿Excel做了一下,下面两个图为地图以及搜索后的结果图。

|

||||

|

||||

1为墙。

|

||||

|

||||

0为可通过的点。

|

||||

|

||||

5为得到的路径。

|

||||

|

||||

红色为起点

|

||||

|

||||

紫色为终点

|

||||

|

||||

绿色忘记删了,没有代表意义

|

||||

|

||||

下图为原地图:

|

||||

|

||||

|

||||

|

||||

下图为搜寻完毕的地图:

|

||||

|

||||

## 总结

|

||||

|

||||

A Star算法算是一个很简单的用于游戏中自动寻路的算法,但是其性能还有有些问题,主要问题在于其需要把每个节点的周围所有可用节点均插入**OpenList\**中,因此相对来说性能损耗几乎都在这个\****OpenList***中,因此A Star算法有很多对其可以优化的算法。

|

||||

|

||||

日后作者将会写一篇关于针对A Star的优化算法即:JPS(jump point search)算法,该算法实际上是对A Star寻路算法的一个改进,A Star 算法在扩展节点时会把节点所有邻居都考虑进去,这样***OpenList\**\**中点的数量会很多,搜索效率较慢。而JPS在A Star算法模型的基础之上,优化了搜索后继节点的操作。A Star的处理是把周边能搜索到的格子,加进OpenList,然后在OpenList中弹出最小值。JPS也是这样的操作,但相对于A Star来说,JPS操作\****OpenList***的次数很少,它会先用一种更高效的方法来搜索需要加进\**\**OpenList\****的节点,从而减少****OpenList\****中节点的数量。

|

||||

|

||||

[^1]: Dijkstra算法 https://baike.baidu.com/item/%E8%BF%AA%E5%85%8B%E6%96%AF%E7%89%B9%E6%8B%89%E7%AE%97%E6%B3%95/23665989?fromtitle=Dijkstra%E7%AE%97%E6%B3%95&fromid=215612 [^2]: Cormen, Thomas H.[1]; Leiserson, Charles E.[2]; Rivest, Ronald L.[3]; Stein, Clifford[4]. Section 24.3: Dijkstra's algorithm. Introduction to Algorithms[5] Second. MIT Press[6] and McGraw–Hill[7]. 2001: 595–601. ISBN 0-262-03293-7[8]. [^3]: 最佳优先搜索算法(Best-First-Search) https://www.jianshu.com/p/9873372fe4b4 [^4]: A Star算法 https://zh.wikipedia.org/wiki/A*%E6%90%9C%E5%B0%8B%E6%BC%94%E7%AE%97%E6%B3%95 [^5]: 路径规划之 A* 算法 https://paul.pub/a-star-algorithm/#id-dijkstra%E7%AE%97%E6%B3%95

|

||||

|

||||

### References

|

||||

618

source/_posts/algorithm/graph/union_find/并查集算法.md

Normal file

@ -0,0 +1,618 @@

|

||||

---

|

||||

title: Union-Find 算法

|

||||

date: 2024-3-19

|

||||

tag:

|

||||

- 算法

|

||||

- 并查集

|

||||

- 图

|

||||

categories: 算法

|

||||

abbrlink: e88a2bb0

|

||||

---

|

||||

|

||||

# Union-Find 算法(并查集算法)

|

||||

|

||||

## ⼀、问题介绍

|

||||

|

||||

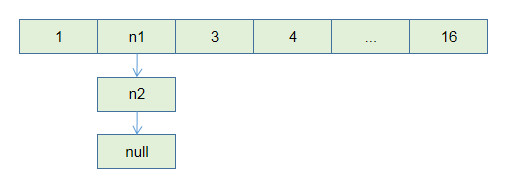

简单说,动态连通性其实可以抽象成给⼀幅图连线。⽐如下⾯这幅图,总共

|

||||

|

||||

有 10 个节点,他们互不相连,分别⽤ 0~9 标记:

|

||||

|

||||

|

||||

|

||||

现在我们的 Union-Find 算法主要需要实现这两个 API:

|

||||

|

||||

```java

|

||||

class UF {

|

||||

/* 将 p 和 q 连接 */

|

||||

public void union(int p, int q);

|

||||

/* 判断 p 和 q 是否连通 */

|

||||

public boolean connected(int p, int q);

|

||||

/* 返回图中有多少个连通分量 */

|

||||

public int count();

|

||||

}

|

||||

```

|

||||

|

||||

这⾥所说的「连通」是⼀种等价关系,也就是说具有如下三个性质:

|

||||

|

||||

1、⾃反性:节点 p 和 p 是连通的。

|

||||

|

||||

2、对称性:如果节点 p 和 q 连通,那么 q 和 p 也连通。

|

||||

|

||||

3、传递性:如果节点 p 和 q 连通, q 和 r 连通,那么 p 和 r 也连通。

|

||||

|

||||

⽐如说之前那幅图,0〜9 任意两个不同的点都不连通,调⽤ connected 都

|

||||

|

||||

会返回 false,连通分量为 10 个。

|

||||

|

||||

如果现在调⽤ union(0, 1) ,那么 0 和 1 被连通,连通分量降为 9 个。

|

||||

|

||||

再调⽤ union(1, 2) ,这时 0,1,2 都被连通,调⽤ connected(0, 2) 也会返回

|

||||

|

||||

true,连通分量变为 8 个。

|

||||

|

||||

|

||||

|

||||

判断这种「等价关系」⾮常实⽤,⽐如说编译器判断同⼀个变量的不同引

|

||||

|

||||

⽤,⽐如社交⽹络中的朋友圈计算等等。

|

||||

|

||||

这样,你应该⼤概明⽩什么是动态连通性了,Union-Find 算法的关键就在

|

||||

|

||||

于 union 和 connected 函数的效率。那么⽤什么模型来表⽰这幅图的连通状

|

||||

|

||||

态呢?⽤什么数据结构来实现代码呢?

|

||||

|

||||

## ⼆、基本思路

|

||||

|

||||

注意我刚才把「模型」和具体的「数据结构」分开说,这么做是有原因的。

|

||||

|

||||

因为我们使⽤森林(若⼲棵树)来表⽰图的动态连通性,⽤数组来具体实现

|

||||

|

||||

这个森林。

|

||||

|

||||

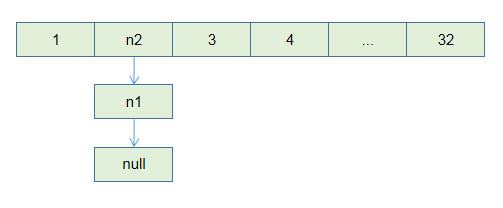

怎么⽤森林来表⽰连通性呢?我们设定树的每个节点有⼀个指针指向其⽗节

|

||||

|

||||

点,如果是根节点的话,这个指针指向⾃⼰。⽐如说刚才那幅 10 个节点的

|

||||

|

||||

图,⼀开始的时候没有相互连通,就是这样:

|

||||

|

||||

|

||||

|

||||

```java

|

||||

class UF {

|

||||

// 记录连通分量

|

||||

private int count;

|

||||

// 节点 x 的节点是 parent[x]

|

||||

private int[] parent;

|

||||

/* 构造函数,n 为图的节点总数 */

|

||||

public UF(int n) {

|

||||

// ⼀开始互不连通

|

||||

this.count = n;

|

||||

// ⽗节点指针初始指向⾃⼰

|

||||

parent = new int[n];

|

||||

for (int i = 0; i < n; i++) {

|

||||

parent[i] = i;

|

||||

}

|

||||

}

|

||||

/* 其他函数 */

|

||||

}

|

||||

```

|

||||

|

||||

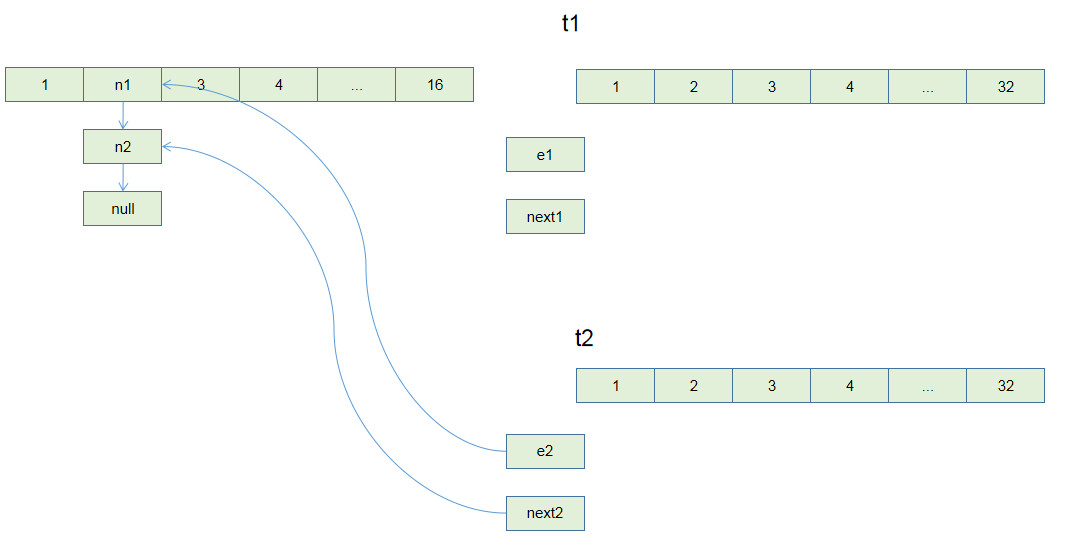

如果某两个节点被连通,则让其中的(任意)⼀个节点的根节点接到另⼀个

|

||||

|

||||

节点的根节点上:

|

||||

|

||||

|

||||

|

||||

```java

|

||||

public void union(int p, int q) {

|

||||

int rootP = find(p);

|

||||

int rootQ = find(q);

|

||||

if (rootP == rootQ)

|

||||

return;

|

||||

// 将两棵树合并为⼀棵

|

||||

parent[rootP] = rootQ;

|

||||

// parent[rootQ] = rootP 也⼀样

|

||||

count--; // 两个分量合⼆为⼀

|

||||

}

|

||||

/* 返回某个节点 x 的根节点 */

|

||||

private int find(int x) {

|

||||

// 根节点的 parent[x] == x

|

||||

while (parent[x] != x)

|

||||

x = parent[x];

|

||||

return x;

|

||||

}

|

||||

/* 返回当前的连通分量个数 */

|

||||

public int count() {

|

||||

return count;

|

||||

}

|

||||

```

|

||||

|

||||

这样,如果节点 p 和 q 连通的话,它们⼀定拥有相同的根节点:

|

||||

|

||||

|

||||

|

||||

```java

|

||||

public boolean connected(int p, int q) {

|

||||

int rootP = find(p);

|

||||

int rootQ = find(q);

|

||||

return rootP == rootQ;

|

||||

}

|

||||

```

|

||||

|

||||

⾄此,Union-Find 算法就基本完成了。是不是很神奇?竟然可以这样使⽤数

|

||||

|

||||

组来模拟出⼀个森林,如此巧妙的解决这个⽐较复杂的问题!

|

||||

|

||||

那么这个算法的复杂度是多少呢?我们发现,主要

|

||||

|

||||

API connected 和 union 中的复杂度都是 find 函数造成的,所以说它们的

|

||||

|

||||

复杂度和 find ⼀样。

|

||||

|

||||

find 主要功能就是从某个节点向上遍历到树根,其时间复杂度就是树的⾼

|

||||

|

||||

度。我们可能习惯性地认为树的⾼度就是 logN ,但这并不⼀定。 logN 的

|

||||

|

||||

⾼度只存在于平衡⼆叉树,对于⼀般的树可能出现极端不平衡的情况,使得

|

||||

|

||||

「树」⼏乎退化成「链表」,树的⾼度最坏情况下可能变成 N 。

|

||||

|

||||

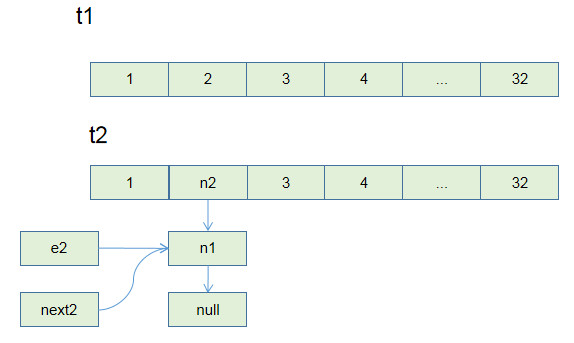

|

||||

|

||||

所以说上⾯这种解法, find , union , connected 的时间复杂度都是 O(N)。

|

||||

|

||||

这个复杂度很不理想的,你想图论解决的都是诸如社交⽹络这样数据规模巨

|

||||

|

||||

⼤的问题,对于 union 和 connected 的调⽤⾮常频繁,每次调⽤需要线性时

|

||||

|

||||

间完全不可忍受。

|

||||

|

||||

问题的关键在于,如何想办法避免树的不平衡呢?只需要略施⼩计即可。

|

||||

|

||||

## 三、平衡性优化

|

||||

|

||||

我们要知道哪种情况下可能出现不平衡现象,关键在于 union 过程:

|

||||

|

||||

```java

|

||||

public void union(int p, int q) {

|

||||

int rootP = find(p);

|

||||

int rootQ = find(q);

|

||||

if (rootP == rootQ)

|

||||

return;

|

||||

// 将两棵树合并为⼀棵

|

||||

parent[rootP] = rootQ;

|

||||

// parent[rootQ] = rootP 也可以

|

||||

count--;

|

||||

//......

|

||||

}

|

||||

```

|

||||

|

||||

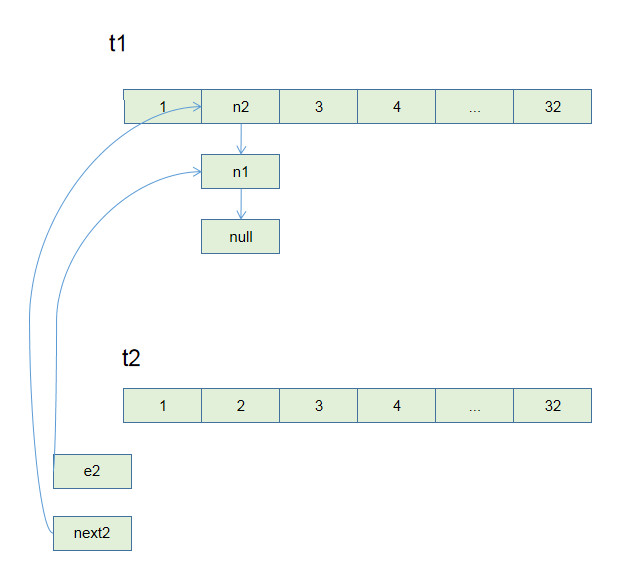

我们⼀开始就是简单粗暴的把 p 所在的树接到 q 所在的树的根节点下⾯,

|

||||

|

||||

那么这⾥就可能出现「头重脚轻」的不平衡状况,⽐如下⾯这种局⾯:

|

||||

|

||||

|

||||

|

||||

⻓此以往,树可能⽣⻓得很不平衡。我们其实是希望,⼩⼀些的树接到⼤⼀

|

||||

|

||||

些的树下⾯,这样就能避免头重脚轻,更平衡⼀些。解决⽅法是额外使⽤⼀

|

||||

|

||||

个 size 数组,记录每棵树包含的节点数,我们不妨称为「重量」:

|

||||

|

||||

```java

|

||||

class UF {

|

||||

private int count;

|

||||

private int[] parent;

|

||||

// 新增⼀个数组记录树的“重量”

|

||||

private int[] size;

|

||||

public UF(int n) {

|

||||

this.count = n;

|

||||

parent = new int[n];

|

||||

// 最初每棵树只有⼀个节点

|

||||

// 重量应该初始化 1

|

||||

size = new int[n];

|

||||

for (int i = 0; i < n; i++) {

|

||||

parent[i] = i; size[i] = 1;

|

||||

}

|

||||

}

|

||||

/* 其他函数 */

|

||||

}

|

||||

```

|

||||

|

||||

⽐如说 size[3] = 5 表⽰,以节点 3 为根的那棵树,总共有 5 个节点。这

|

||||

|

||||

样我们可以修改⼀下 union ⽅法:

|

||||

|

||||

```java

|

||||

public void union(int p, int q) {

|

||||

int rootP = find(p);

|

||||

int rootQ = find(q);

|

||||

if (rootP == rootQ)

|

||||

return;

|

||||

// ⼩树接到⼤树下⾯,较平衡

|

||||

if (size[rootP] > size[rootQ]) {

|

||||

parent[rootQ] = rootP; size[rootP] += size[rootQ];

|

||||

} else {

|

||||

parent[rootP] = rootQ; size[rootQ] += size[rootP];

|

||||

}

|

||||

count--;

|

||||

}

|

||||

```

|

||||

|

||||

这样,通过⽐较树的重量,就可以保证树的⽣⻓相对平衡,树的⾼度⼤致

|

||||

|

||||

在 logN 这个数量级,极⼤提升执⾏效率。

|

||||

|

||||

此时, find , union , connected 的时间复杂度都下降为 O(logN),即便数据

|

||||

|

||||

规模上亿,所需时间也⾮常少

|

||||

|

||||

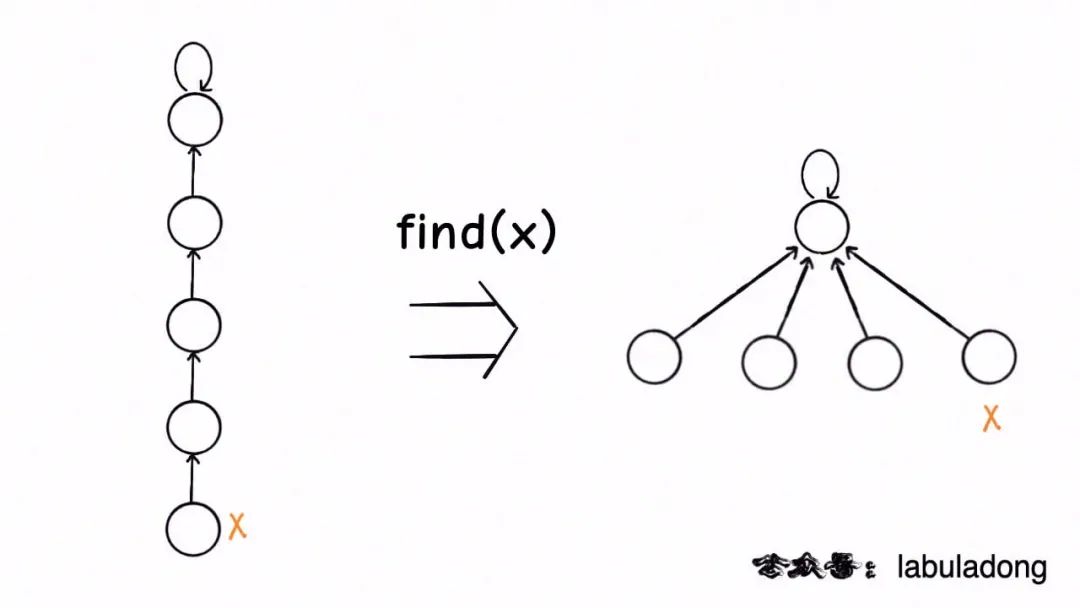

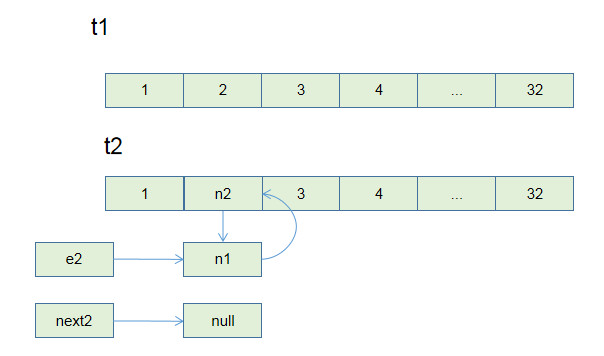

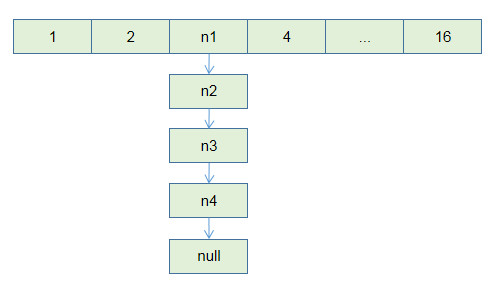

## 四、路径压缩

|

||||

|

||||

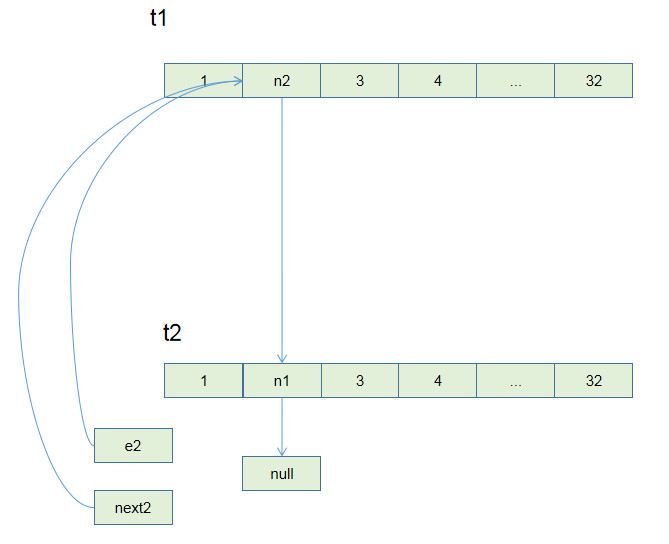

这步优化特别简单,所以⾮常巧妙。我们能不能进⼀步压缩每棵树的⾼度,

|

||||

|

||||

使树⾼始终保持为常数?

|

||||

|

||||

|

||||

|

||||

这样 find 就能以 O(1) 的时间找到某⼀节点的根节点,相应

|

||||

|

||||

的, connected 和 union 复杂度都下降为 O(1)。

|

||||

|

||||

要做到这⼀点,⾮常简单,只需要在 find 中加⼀⾏代码:

|

||||

|

||||

```java

|

||||

private int find(int x) {

|

||||

while (parent[x] != x) {

|

||||

// 进⾏路径压缩

|

||||

parent[x] = parent[parent[x]];

|

||||

x = parent[x];

|

||||

}

|

||||

return x;

|

||||

}

|

||||

```

|

||||

|

||||

这个操作有点匪夷所思,看个 GIF 就明⽩它的作⽤了(为清晰起⻅,这棵

|

||||

|

||||

树⽐较极端):

|

||||

|

||||

|

||||

|

||||

用语言描述就是,每次 while 循环都会把一对儿父子节点改到同一层,这样每次调用`find`函数向树根遍历的同时,顺手就将树高缩短了,最终所有树高都会是一个常数,那么所有方法的复杂度也就都是 O(1)。

|

||||

|

||||

> PS:读者可能会问,这个 GIF 图的`find`过程完成之后,树高确实缩短了,但是如果更高的树,压缩后高度可能依然很大呀?不能这么想。因为这个 GIF 的情景是我编出来方便大家理解路径压缩的,但是实际中,每次`find`都会进行路径压缩,所以树本来就不可能增长到这么高,这种担心是多余的。

|

||||

|

||||

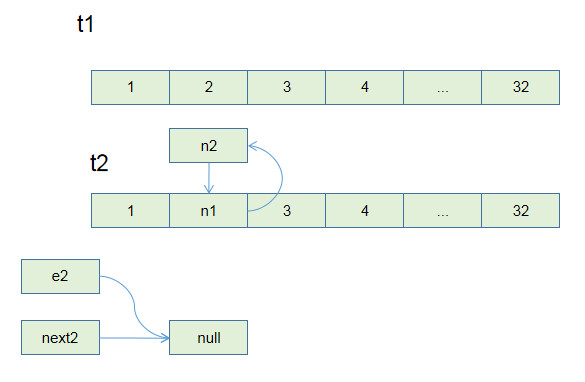

路径压缩的第二种写法是这样:

|

||||

|

||||

```java

|

||||

// 第二种路径压缩的 find 方法

|

||||

public int find(int x) {

|

||||

if (parent[x] != x) {

|

||||

parent[x] = find(parent[x]);

|

||||

}

|

||||

return parent[x];

|

||||

}

|

||||

```

|

||||

|

||||

我一度认为这种递归写法和第一种迭代写法做的事情一样,但实际上是我大意了,有读者指出这种写法进行路径压缩的效率是高于上一种解法的。

|

||||

|

||||

这个递归过程有点不好理解,你可以自己手画一下递归过程。我把这个函数做的事情翻译成迭代形式,方便你理解它进行路径压缩的原理:

|

||||

|

||||

```java

|

||||

// 这段迭代代码方便你理解递归代码所做的事情

|

||||

public int find(int x) {

|

||||

// 先找到根节点

|

||||

int root = x;

|

||||

while (parent[root] != root) {

|

||||

root = parent[root];

|

||||

}

|

||||

// 然后把 x 到根节点之间的所有节点直接接到根节点下面

|

||||

int old_parent = parent[x];

|

||||

while (x != root) {

|

||||

parent[x] = root;

|

||||

x = old_parent;

|

||||

old_parent = parent[old_parent];

|

||||

}

|

||||

return root;

|

||||

}

|

||||

```

|

||||

|

||||

这种路径压缩的效果如下:

|

||||

|

||||

|

||||

|

||||

比起第一种路径压缩,显然这种方法压缩得更彻底,直接把一整条树枝压平,一点意外都没有,所以从效率的角度来说,推荐你使用这种路径压缩算法。

|

||||

|

||||

**另外,如果路径压缩技巧将树高保持为常数了,那么`size`数组的平衡优化就不是特别必要了**。

|

||||

|

||||

所以你一般看到的 Union Find 算法应该是如下实现:

|

||||

|

||||

```java

|

||||

class UF {

|

||||

// 连通分量个数

|

||||

private int count;

|

||||

// 存储每个节点的父节点

|

||||

private int[] parent;

|

||||

|

||||

// n 为图中节点的个数

|

||||

public UF(int n) {

|

||||

this.count = n;

|

||||

parent = new int[n];

|

||||

for (int i = 0; i < n; i++) {

|

||||

parent[i] = i;

|

||||

}

|

||||

}

|

||||

|

||||

// 将节点 p 和节点 q 连通

|

||||

public void union(int p, int q) {

|

||||

int rootP = find(p);

|

||||

int rootQ = find(q);

|

||||

if (rootP == rootQ)

|

||||

return;

|

||||

parent[rootQ] = rootP;

|

||||

// 两个连通分量合并成一个连通分量

|

||||

count--;

|

||||

}

|

||||

|

||||

// 判断节点 p 和节点 q 是否连通

|

||||

public boolean connected(int p, int q) {

|

||||

int rootP = find(p);

|

||||

int rootQ = find(q);

|

||||

return rootP == rootQ;

|

||||

}

|

||||

|

||||

public int find(int x) {

|

||||

if (parent[x] != x) {

|

||||

parent[x] = find(parent[x]);

|

||||

}

|

||||

return parent[x];

|

||||

}

|

||||

|

||||

// 返回图中的连通分量个数

|

||||

public int count() {

|

||||

return count;

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

Union-Find 算法的复杂度可以这样分析:构造函数初始化数据结构需要 O(N) 的时间和空间复杂度;连通两个节点`union`、判断两个节点的连通性`connected`、计算连通分量`count`所需的时间复杂度均为 O(1)。

|

||||

|

||||

到这里,相信你已经掌握了 Union-Find 算法的核心逻辑,总结一下我们优化算法的过程:

|

||||

|

||||

1、用`parent`数组记录每个节点的父节点,相当于指向父节点的指针,所以`parent`数组内实际存储着一个森林(若干棵多叉树)。

|

||||

|

||||

2、用`size`数组记录着每棵树的重量,目的是让`union`后树依然拥有平衡性,保证各个 API 时间复杂度为 O(logN),而不会退化成链表影响操作效率。

|

||||

|

||||

3、在`find`函数中进行路径压缩,保证任意树的高度保持在常数,使得各个 API 时间复杂度为 O(1)。使用了路径压缩之后,可以不使用`size`数组的平衡优化。

|

||||

|

||||

下面我们看一些具体的并查集题目。

|

||||

|

||||

## 五、题目实践

|

||||

|

||||

力扣第 323 题「无向图中连通分量的数目」就是最基本的连通分量题目:

|

||||

|

||||

给你输入一个包含`n`个节点的图,用一个整数`n`和一个数组`edges`表示,其中`edges[i] = [ai, bi]`表示图中节点`ai`和`bi`之间有一条边。请你计算这幅图的连通分量个数。

|

||||

|

||||

函数签名如下:

|

||||

|

||||

```java

|

||||

int countComponents(int n, int[][] edges)

|

||||

```

|

||||

|

||||

这道题我们可以直接套用`UF`类来解决:

|

||||

|

||||

```java

|

||||

public int countComponents(int n, int[][] edges) {

|

||||

UF uf = new UF(n);

|

||||

// 将每个节点进行连通

|

||||

for (int[] e : edges) {

|

||||

uf.union(e[0], e[1]);

|

||||

}

|

||||

// 返回连通分量的个数

|

||||

return uf.count();

|

||||

}

|

||||

|

||||

class UF {

|

||||

// 见上文

|

||||

}

|

||||

```

|

||||

|

||||

****另外,一些使用 DFS 深度优先算法解决的问题,也可以用 Union-Find 算法解决**。

|

||||

|

||||

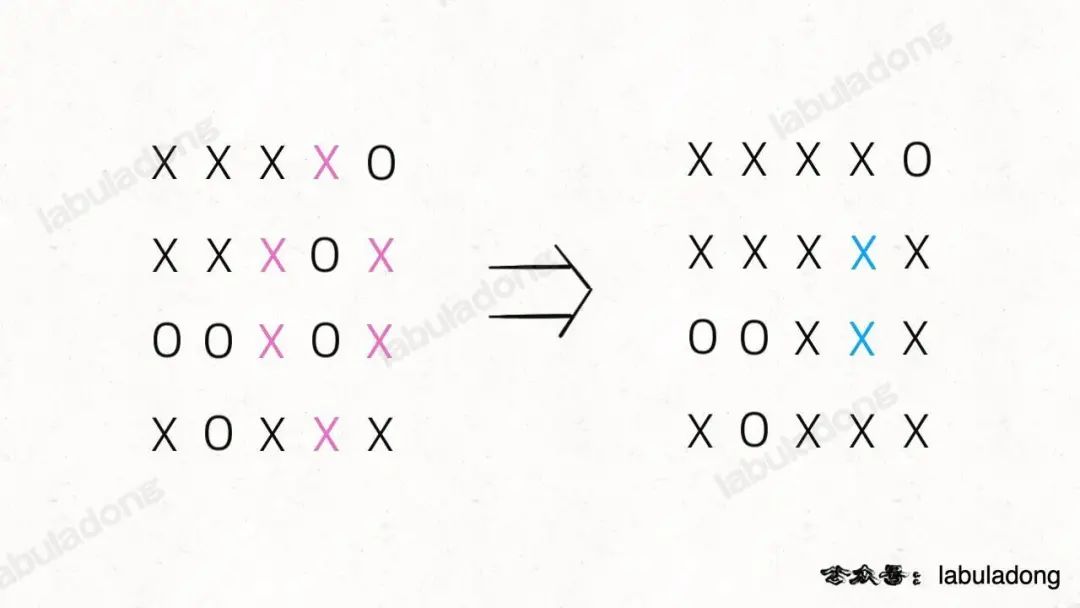

比如力扣第 130 题「被围绕的区域」:

|

||||

|

||||

给你一个 M×N 的二维矩阵,其中包含字符`X`和`O`,让你找到矩阵中**四面**被`X`围住的`O`,并且把它们替换成`X`。

|

||||

|

||||

```java

|

||||

void solve(char[][] board);

|

||||

```

|

||||

|

||||

注意哦,必须是四面被围的`O`才能被换成`X`,也就是说边角上的`O`一定不会被围,进一步,与边角上的`O`相连的`O`也不会被`X`围四面,也不会被替换。**

|

||||

|

||||

|

||||

|

||||

> PS:这让我想起小时候玩的棋类游戏「黑白棋」,只要你用两个棋子把对方的棋子夹在中间,对方的子就被替换成你的子。可见,占据四角的棋子是无敌的,与其相连的边棋子也是无敌的(无法被夹掉)。

|

||||

|

||||

其实这个问题应该归为 [岛屿系列问题](https://mp.weixin.qq.com/s?__biz=MzAxODQxMDM0Mw==&mid=2247492234&idx=1&sn=fef28b1ca7639e056104374ddc9fbf0b&scene=21#wechat_redirect) 使用 DFS 算法解决:

|

||||

|

||||

先用 for 循环遍历棋盘的**四边**,用 DFS 算法把那些与边界相连的`O`换成一个特殊字符,比如`#`;然后再遍历整个棋盘,把剩下的`O`换成`X`,把`#`恢复成`O`。这样就能完成题目的要求,时间复杂度 O(MN)。

|

||||

|

||||

但这个问题也可以用 Union-Find 算法解决,虽然实现复杂一些,甚至效率也略低,但这是使用 Union-Find 算法的通用思想,值得一学。

|

||||

|

||||

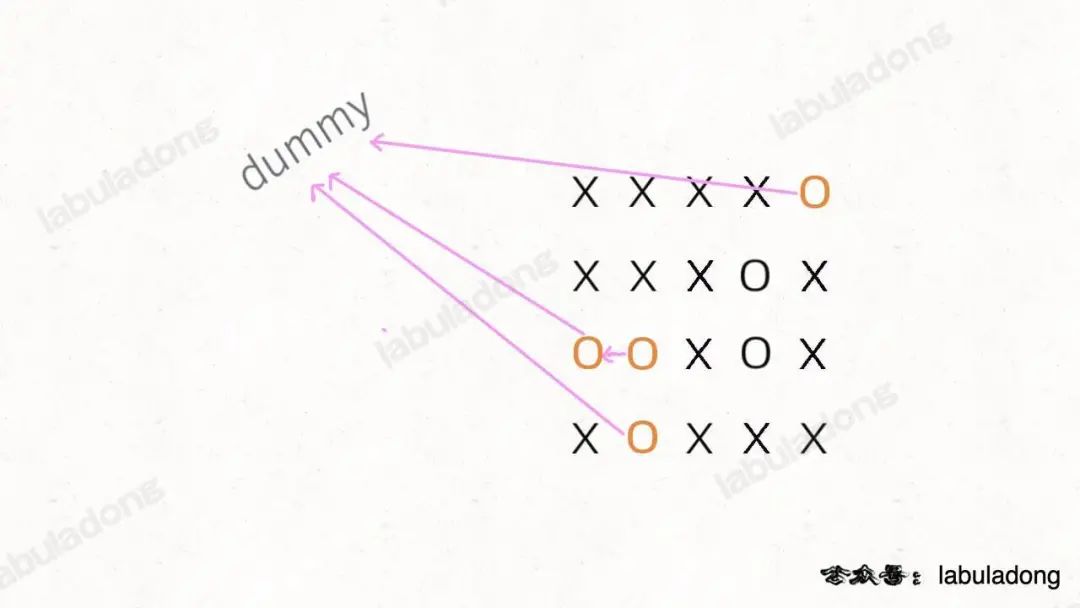

**你可以把那些不需要被替换的`O`看成一个拥有独门绝技的门派,它们有一个共同「祖师爷」叫`dummy`,这些`O`和`dummy`互相连通,而那些需要被替换的`O`与`dummy`不连通**。

|

||||

|

||||

|

||||

|

||||

这就是 Union-Find 的核心思路,明白这个图,就很容易看懂代码了。

|

||||

|

||||

首先要解决的是,根据我们的实现,Union-Find 底层用的是一维数组,构造函数需要传入这个数组的大小,而题目给的是一个二维棋盘。

|

||||

|

||||

这个很简单,二维坐标`(x,y)`可以转换成`x * n + y`这个数(`m`是棋盘的行数,`n`是棋盘的列数),**敲黑板,这是将二维坐标映射到一维的常用技巧**。

|

||||

|

||||

其次,我们之前描述的「祖师爷」是虚构的,需要给他老人家留个位置。索引`[0.. m*n-1]`都是棋盘内坐标的一维映射,那就让这个虚拟的`dummy`节点占据索引`m * n`好了。

|

||||

|

||||

看解法代码:

|

||||

|

||||

```java

|

||||

void solve(char[][] board) {

|

||||

if (board.length == 0) return;

|

||||

|

||||

int m = board.length;

|

||||

int n = board[0].length;

|

||||

// 给 dummy 留一个额外位置

|

||||

UF uf = new UF(m * n + 1);

|

||||

int dummy = m * n;

|

||||

// 将首列和末列的 O 与 dummy 连通

|

||||

for (int i = 0; i < m; i++) {

|

||||

if (board[i][0] == 'O')

|

||||

uf.union(i * n, dummy);

|

||||

if (board[i][n - 1] == 'O')

|

||||

uf.union(i * n + n - 1, dummy);

|

||||

}

|

||||

// 将首行和末行的 O 与 dummy 连通

|

||||

for (int j = 0; j < n; j++) {

|

||||

if (board[0][j] == 'O')

|

||||

uf.union(j, dummy);

|

||||

if (board[m - 1][j] == 'O')

|

||||

uf.union(n * (m - 1) + j, dummy);

|

||||

}

|

||||

// 方向数组 d 是上下左右搜索的常用手法

|

||||

int[][] d = new int[][]{{1,0}, {0,1}, {0,-1}, {-1,0}};

|

||||

for (int i = 1; i < m - 1; i++)

|

||||

for (int j = 1; j < n - 1; j++)

|

||||

if (board[i][j] == 'O')

|

||||

// 将此 O 与上下左右的 O 连通

|

||||

for (int k = 0; k < 4; k++) {

|

||||

int x = i + d[k][0];

|

||||

int y = j + d[k][1];

|

||||

if (board[x][y] == 'O')

|

||||

uf.union(x * n + y, i * n + j);

|

||||

}

|

||||

// 所有不和 dummy 连通的 O,都要被替换

|

||||

for (int i = 1; i < m - 1; i++)

|

||||

for (int j = 1; j < n - 1; j++)

|

||||

if (!uf.connected(dummy, i * n + j))

|

||||

board[i][j] = 'X';

|

||||

}

|

||||

|

||||

class UF {

|

||||

// 见上文

|

||||

}

|

||||

```

|

||||

|

||||

这段代码很长,其实就是刚才的思路实现,只有和边界`O`相连的`O`才具有和`dummy`的连通性,他们不会被替换。

|

||||

|

||||

其实用 Union-Find 算法解决这个简单的问题有点杀鸡用牛刀,它可以解决更复杂,更具有技巧性的问题,**主要思路是适时增加虚拟节点,想办法让元素「分门别类」,建立动态连通关系**。

|

||||

|

||||

力扣第 990 题「等式方程的可满足性」用 Union-Find 算法就显得十分优美了,题目是这样:

|

||||

|

||||

给你一个数组`equations`,装着若干字符串表示的算式。每个算式`equations[i]`长度都是 4,而且只有这两种情况:`a==b`或者`a!=b`,其中`a,b`可以是任意小写字母。你写一个算法,如果`equations`中所有算式都不会互相冲突,返回 true,否则返回 false。

|

||||

|

||||

比如说,输入`["a==b","b!=c","c==a"]`,算法返回 false,因为这三个算式不可能同时正确。

|

||||

|

||||

再比如,输入`["c==c","b==d","x!=z"]`,算法返回 true,因为这三个算式并不会造成逻辑冲突。

|

||||

|

||||

我们前文说过,动态连通性其实就是一种等价关系,具有「自反性」「传递性」和「对称性」,其实`==` 关系也是一种等价关系,具有这些性质。所以这个问题用 Union-Find 算法就很自然。

|

||||

|

||||

**核心思想是,将`equations`中的算式根据`==`和`!=`分成两部分,先处理`==`算式,使得他们通过相等关系各自勾结成门派(连通分量);然后处理`!=`算式,检查不等关系是否破坏了相等关系的连通性**。

|

||||

|

||||

```java

|

||||

boolean equationsPossible(String[] equations) {

|

||||

// 26 个英文字母

|

||||

UF uf = new UF(26);

|

||||

// 先让相等的字母形成连通分量

|

||||

for (String eq : equations) {

|

||||

if (eq.charAt(1) == '=') {

|

||||

char x = eq.charAt(0);

|

||||

char y = eq.charAt(3);

|

||||

uf.union(x - 'a', y - 'a');

|

||||

}

|

||||

}

|

||||

// 检查不等关系是否打破相等关系的连通性

|

||||

for (String eq : equations) {

|

||||

if (eq.charAt(1) == '!') {

|

||||

char x = eq.charAt(0);

|

||||

char y = eq.charAt(3);

|

||||

// 如果相等关系成立,就是逻辑冲突

|

||||

if (uf.connected(x - 'a', y - 'a'))

|

||||

return false;

|

||||

}

|

||||

}

|

||||

return true;

|

||||

}

|

||||

|

||||

class UF {

|

||||

// 见上文

|

||||

}

|

||||

```

|

||||

|

||||

至此,这道判断算式合法性的问题就解决了,借助 Union-Find 算法,是不是很简单呢?

|

||||

|

||||

最后,Union-Find 算法也会在一些其他经典图论算法中用到,比如判断「图」和「树」,以及最小生成树的计算,详情见 [Kruskal 最小生成树算法](https://mp.weixin.qq.com/s?__biz=MzAxODQxMDM0Mw==&mid=2247492575&idx=1&sn=bf63eb391351a0dfed0d03e1ac5992e7&scene=21#wechat_redirect)。

|

||||

|

||||

## 六、最后总结

|

||||

|

||||

我们先来看⼀下完整代码:

|

||||

|

||||

```java

|

||||

class UF {

|

||||

// 连通分量个数

|

||||

private int count;

|

||||

// 存储⼀棵树

|

||||

private int[] parent;

|

||||

// 记录树的“重量”

|

||||

private int[] size;

|

||||

|

||||

public UF(int n) {

|

||||

this.count = n;

|

||||

parent = new int[n];

|

||||

size = new int[n];

|

||||

for (int i = 0; i < n; i++) {

|

||||

parent[i] = i;

|

||||

size[i] = 1;

|

||||

}

|

||||

}

|

||||

|

||||

public void union(int p, int q) {

|

||||

int rootP = find(p);

|

||||

int rootQ = find(q);

|

||||

if (rootP == rootQ)

|

||||

return;

|

||||

// ⼩树接到⼤树下⾯,较平衡

|

||||

if (size[rootP] > size[rootQ]) {

|

||||

parent[rootQ] = rootP;

|

||||

size[rootP] += size[rootQ];

|

||||

} else {

|

||||

parent[rootP] = rootQ;

|

||||

size[rootQ] += size[rootP];

|

||||

}

|

||||

count--;

|

||||

}

|

||||

|

||||

public boolean connected(int p, int q) {

|

||||

int rootP = find(p);

|

||||

int rootQ = find(q);

|

||||

return rootP == rootQ;

|

||||

}

|

||||

|

||||

private int find(int x) {

|

||||

while (parent[x] != x) {

|

||||

// 进⾏路径压缩

|

||||

parent[x] = parent[parent[x]];

|

||||

x = parent[x];

|

||||

}

|

||||

return x;

|

||||

}

|

||||

|

||||

public int count() {

|

||||

return count;

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

Union-Find 算法的复杂度可以这样分析:构造函数初始化数据结构需要

|

||||

|

||||

O(N) 的时间和空间复杂度;连通两个节点 union 、判断两个节点的连通

|

||||

|

||||

性 connected 、计算连通分量 count 所需的时间复杂度均为 O(1)。

|

||||

|

After Width: | Height: | Size: 235 KiB |

|

After Width: | Height: | Size: 250 KiB |

|

After Width: | Height: | Size: 217 KiB |

|

After Width: | Height: | Size: 255 KiB |

|

After Width: | Height: | Size: 253 KiB |

|

After Width: | Height: | Size: 238 KiB |

|

After Width: | Height: | Size: 259 KiB |

|

After Width: | Height: | Size: 221 KiB |

272

source/_posts/c++/article/2022/02/07/CPlusPlus编码优化之减少冗余拷贝或赋值.md

Normal file

@ -0,0 +1,272 @@

|

||||

---

|

||||

title: C++编码优化之减少冗余拷贝或赋值

|

||||

tag:

|

||||

- c++

|

||||

categories: c++

|

||||

abbrlink: 97da918c

|

||||

---

|

||||

|

||||

# C++编码优化之减少冗余拷贝或赋值

|

||||

|

||||

## 临时变量

|

||||

|

||||

目前遇到的一些产生临时变量的情况:函数实参、函数返回值、隐式类型转换、多余的拷贝。

|

||||

|

||||

### 1. 函数实参

|

||||

|

||||

这点应该比较容易理解,函数参数,如果是实参传递的话,函数体里的修改并不会影响调用时传入的参数的值。那么函数体里操作的对象肯定是函数调用的过程中产生出来的。

|

||||

|

||||

那么这种情况我们该怎么办呢?

|

||||

|

||||

如果 `callee` 中确实要修改这个对象,但是 `caller` 又不想 `callee` 的修改影响到原来的值,那么这个临时变量就是必须的了,不需要也没办法避免。

|

||||

|

||||

如果 `callee`中根本没有修改这个对象,或者 `callee` 中这个参数本身就是 `const` 型的,那么将实参传递改为引用传递是个不错的选择(如果是基本类型的函数实参,则没有必要改为引用),可以减少一个临时变量而且不会带来任何损失。

|

||||

|

||||

另外,推荐一个静态代码检查工具 `cppcheck`,这个工具可以提示非基本类型的 `const` 实参改为引用。

|

||||

|

||||

### 2. 函数返回值(返回对象)

|

||||

|

||||

函数返回值的情况比较复杂,因为编译器在这方面做了很多优化,编译器优化到何种程度我也没追根究底研究过。

|

||||

|

||||

在没开任何优化选项的时候,`gcc` 也优化了一些简单的返回对象的情况。

|

||||

|

||||

先看一段代码:

|

||||

|

||||

```

|

||||

A createA(int a)

|

||||

{

|

||||

A tmp;

|

||||

tmp._a=a;

|

||||

return tmp;

|

||||

}

|

||||

```

|

||||

|

||||

抛开所有优化不谈,函数中 `createA` 应该有一个构造操作(`tmp` 对象生成)和一个拷贝构造操作(`tmp` 对象返回时)。

|

||||

|

||||

于是有些编译器尝试对函数返回时的拷贝构造进行优化:

|

||||

|

||||

```

|

||||

A createA(int a)

|

||||

{

|

||||

return A(a);

|

||||

}

|

||||

```

|

||||

|

||||

第一步可以被优化的拷贝构造就是上面的这种情况,即 `RVO(return value optimization)`,这时候只能在函数返回一个未命名变量的时候进行优化。

|

||||

|

||||

后来更进一步,可以在函数返回命名变量的时候也进行优化了,这就是 `NRVO(named return value optimization)`。

|

||||

|

||||

但是这时候,还有一种情况不能优化的情况是:如果 `createA`函数内部不同的分支返回不同的对象。

|

||||

|

||||

```

|

||||

A createA(int a)

|

||||

{

|

||||

if(a%2==0)

|

||||

{

|

||||

A tmp;

|

||||

tmp._a = 2;

|

||||

return tmp;

|

||||

}

|

||||

else

|

||||

{

|

||||

A tmp;

|

||||

tmp._a = 1;

|

||||

return tmp;

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

比如上面这段代码,我在 `gcc 3.4.5` 的情况下测试,发现这种情况是不能优化的。

|

||||

|

||||

但是也不排除 `gcc` 更高的版本或者某些在这方面做得更优秀的编译器已经可以优化这种情况。

|

||||

|

||||

### 3. 隐式类型转换

|

||||

|

||||

代码中的一些类型的隐式转换也会产生临时变量,比如:

|

||||

|

||||

```

|

||||

class A

|

||||

{

|

||||

public:

|

||||

A(int a=0):_a(a)

|

||||

{

|

||||

cout<<"constructor"<<endl;

|

||||

}

|

||||

A(const A &a)

|

||||

{

|

||||

cout<<"copy constructor"<<endl;

|

||||

this->_a = a._a;

|

||||

}

|

||||

A& operator=(const A&a)

|

||||

{

|

||||

cout<<"operator="<<endl;

|

||||

this->_a = a._a;

|

||||

return *this;

|

||||

}

|

||||

int _a;

|

||||

};

|

||||

int main()

|

||||

{

|

||||

A a1;

|

||||

a1 = 3;

|

||||

return 0;

|

||||

}

|

||||

```

|

||||

|

||||

在 a1 = 3 执行时会首先调用 `A(3)` 产生一个临时对象,然后调用`operator=(const A& a)`。

|

||||

|

||||

这种情况下,我们只要实现一个`A::operator=(int)`函数就可以避免这个临时对象的产生了。

|

||||

|

||||

当然,这只是一个最简单的例子,不过思路是差不多的。

|

||||

|

||||

### 4. 多余的拷贝

|

||||

|

||||

这种情况应该比较少,也比较简单,个人感觉,这种情况主要是疏忽引起的。

|

||||

|

||||

是这样一种情况:

|

||||

|

||||

有个线程级的结构体`thread_data_t *pthread_data`,里面包含请求包的各种数据,在几处使用的使用使用了`const A a = pthread_data->getA()`。

|

||||

|

||||

`getA()`的实现简单来说是返回了`thread_data_t`内部的A的成员。

|

||||

|

||||

因为在一次请求的处理过程中`thread_data_t`内部的 A 的成员不会改变,调用者用`const A a`来接收这个对象就表明调用者也不会改变返回的 A 成员。

|

||||

|

||||

因此,其实完全可以让`getA()`返回A成员的引用,调用者同样用引用来接收:`const A & a = pthread_data->getA()`。

|

||||

|

||||

这样就完全就避免了一次多余的拷贝。

|

||||

|

||||

## 非临时变量

|

||||

|

||||

遇到的一些非临时变量情况有:`stl vector` 的增长引起拷贝构造、`vector` 的赋值、`std::sort` 操作

|

||||

|

||||

### 1. vector的增长

|

||||

|

||||

先简单介绍一下`vector`的增长机制:每次`push_back`时,如果发现原来`vector`的空间用完,会把`vector`调整到原来的 2 倍( sgi 的实现,`visual studio` 的实现好像是 1.5 倍)。因为 `vector` 空间是连续存储的,这里就有一个问题,如果原来 `vector` 地址后面空余的空间没有被使用,那么`vector`继续把后面的地址申请来就可以扩展其空间了。但是如果后面的空间不够了呢?那就要重新申请一个`2*current_size`大小的空间,然后把`vector`当前,也就是`current_size`的内容拷贝到刚申请的那块空间中去,这时就引起了对象的拷贝操作了。

|

||||

|

||||

假设`vector`初始大小是 0,我们通过`push_back`加入了 10 个对象,以`sgi`实现的两倍增长为例,再假设每次调整`vector`空间的时候都需要调整地址,一共引入了多少次无用的拷贝?

|

||||

|

||||

因为`vector`空间是`1->2->4->8->16`增长的,拷贝的次数一共是四次,每次拷贝对象分别是`1、2、4、8`个。所以答案是`1+2+4+8=15`。

|

||||

|

||||

很容易看出规律,拷贝对象的个数等于最终`vector`空间大小减一。

|

||||

|

||||

那么如果`vector`大小最终会涨到 1000,1W 呢?数据就很可观了。

|

||||

|

||||

我接触过好几个服务,最终`vector`可能会增长到 10W 左右的。如果`vector`要放入 10W 个元素,那么就会开辟`131072`的空间,也就是说最多会引入 13W 次的对象拷贝,而这个拷贝操作是无效的、是可以避免的。

|

||||

|

||||

其实要避免`vector`增长引入的拷贝也很简单,在`push_back`之前先调用`reserve`申请一个估算的最大空间。

|

||||

|

||||

比如我们之前优化的一些服务,预期`vector`最大可能会增长到 10W,那么直接调用`v.reserve(100000)`就可以了。

|

||||

|

||||

当然,这也许会引起一些内存使用的浪费,这就需要使用时注意权衡了。

|

||||

|

||||

但如果你的服务是一直运行的,而且这个`vecto`r对象也是常驻内存的,个人觉得完全可以`reserve`一个最大的空间。因为`vector`空间增长之后,就算调用`clear`清除所有元素,内存也是不会释放的。除非使用和空`vector`交换的方式强制释放它的内存。

|

||||

|

||||

### 2. vector的赋值

|

||||

|

||||

遇到过这样一种情况,在一个函数接受一个`vector &`作为输入,经过一系列处理得到一个临时的`vector`,并在函数返回前将这个临时的`vector`赋值给作为参数的`vector &`作为返回值。简化一下代码如下:

|

||||

|

||||

```

|

||||

void cal_result(vector<int> &input_ret)

|

||||

{

|

||||

vector<int> tmp;

|

||||

for(...)

|

||||

{

|

||||

... // input_ret will be used

|

||||

//fill tmp

|

||||

}

|

||||

input_ret = tmp;

|

||||

}

|

||||

```

|

||||

|

||||

这里,我们可以注意到函数返回后 `tmp` 对象也就消失了,不会被继续使用,所以如果可以的话,我们根本不需要返回 `tmp`的拷贝,直接返回 `tmp` 占用的空间就可以了。

|

||||

|

||||

那么怎么可以直接返回 `tmp` 而不引起拷贝呢?是不是可以这样想,我们把 `tmp`这个`vector`指向的地址赋值给`input_ret`,把`tmp`指向的空间和大小设置为 0 就可以了?

|

||||

|

||||

那么我们完全可以使用`vector`的`swap`操作。它只是将两个`vector`指向空间等等信息交换了一下,而不会引起元素的拷贝,它的操作是常数级的,和交互对象中元素数目无关。

|

||||

|

||||

因此将上述代码改为:

|

||||

|

||||

```

|

||||

void cal_result(vector<int> &input_ret)

|

||||

{

|

||||

vector<int> tmp;

|

||||

for(...)

|

||||

{

|

||||

... // input_ret will be used

|

||||

//fill tmp

|

||||

}

|

||||

input_ret.swap(tmp);

|

||||

}

|

||||

```

|

||||

|

||||

可以减少`tmp`元素的拷贝操作,大大提高了该函数的处理效率。(提高多少,要看`tmp`中所有元素拷贝的代价多大)

|

||||

|

||||

### 3. std::sort操作

|

||||

|

||||

在为一个模块做性能优化的时候,发现一个`vector`的`sort`的操作十分消耗性能,占了整个模块消耗`CPU 10%`以上。

|

||||

|

||||

使用`gperftools`的`cpu profiler`分析了一下数据,发现`sort`操作调用了元素的拷贝构造和赋值函数,这才是消耗性能的原因。

|

||||

|

||||

进一步分析,`vector`中的元素对象特别庞大,对象中又嵌套了其他对象且嵌套了好几层,因此函数的拷贝和赋值的操作代价会比较大。

|

||||

|

||||

而`std::sort`采用的是内省排序+插入排序的方式( sgi 的实现),不可避免地会引入对象的交换和移动。(其实不管怎么排序都避免不了交换和移动的吧...)

|

||||

|

||||

因此,要优化这句`std::sort`操作,还需要减少对象交换或者提高交换的效率上入手。

|

||||

|

||||

1. 减少对象的交换

|

||||

|

||||

我们采用的减少对象交换的方式是:先使用`index`的方式进行排序,排序好了之后,把原来的`vector`中的对象按照`index`排序的结果最终做一次拷贝,拷贝到这个对象排序后应该在的位置。

|

||||

|

||||

1. 提高交换的效率

|

||||

|

||||

如果对象的实现是如下这样的:

|

||||

|

||||

```

|

||||

class A

|

||||

{

|

||||

public:

|

||||

A(const char* src)

|

||||

{

|

||||

_len = strlen(src);

|

||||

_content = new char[_len];

|

||||

memcpy(_content,src,_len);

|

||||

}

|

||||

A(const A &a)

|

||||

{

|

||||

*this = a;

|

||||

}

|

||||

A& operator=(const A&a)

|

||||

{

|

||||

_len = a._len;

|

||||

_content = new char[_len];

|

||||

memcpy(_content,src,_len);

|

||||

}

|

||||

private:

|

||||

char *_content;

|

||||

int _len;

|

||||

};

|

||||

```

|

||||

|

||||

这里为了保持代码简短,省略了部分实现且没考虑一些安全性的校验。

|

||||

|

||||

那么在对象交换的时候,其实是没有必要调用拷贝构造函数和赋值函数的(`std::swap`的默认实现),直接交换两个对象的`_content`和`_len`值就好了。如果调用拷贝构造函数和赋值函数的话,不可避免还要引入`new、memcpy、strlen、delete`等等操作。

|

||||

|

||||

这种情况下,我们完全可以针对 A 的实现,重载全局的`swap`操作。这样`sort`的过程中就可以调用我们自己实现的高效的`swap`了。

|

||||

|

||||

如下代码可以重载我们 A 函数的`swap`实现:

|

||||

|

||||

```

|

||||

namespace std

|

||||

{

|

||||

template<>

|

||||

void swap<A>(A &a1,A& a2)

|

||||

{

|

||||

cout<<"swap A"<<endl;

|

||||

int tmp = a1._a;

|

||||

a1._a = a2._a;

|

||||

a2._a = tmp;

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

因为调用堆精度问题和编译优化的问题,有时候也可能分析不到 `sort` 是因为调用了元素对象的拷贝构造和赋值函数所以才效率比较低。所以发现`sort`消耗性能的时候,可以看看是否是因为`sort`对象过大造成的,积累一个`common sense`吧。

|

||||

2114

source/_posts/c++/base/memory/Cplusplus内存管理.md

Normal file

447

source/_posts/c++/base/memory/一起探索Cplusplus类内存分布.md

Normal file

@ -0,0 +1,447 @@

|

||||

---

|

||||

title: 一起探索Cplusplus类内存分布

|

||||

tag:

|

||||

- memory

|

||||

- c++

|

||||

categories:

|

||||

- c++

|

||||

abbrlink: 97623f3c

|

||||

---

|

||||

|

||||

# 一起探索Cplusplus类内存分布

|

||||

C++ 类中内存分布具体是怎么样,尤其是C++中含有继承、虚函数、虚拟继承以及菱形继承等等情况下。

|

||||

|

||||

由于在`linux`下没有`windows`下显示直观,我们采用`vs2015`进行调试。

|

||||

|

||||

------

|

||||

|

||||

- **部署环境**

|

||||

|

||||

我们在 `属性->C/C++ ->命令行 -> /d1 reportSingleClassLayoutXXX` ,XXX表示类名;

|

||||

|

||||

|

||||

|

||||

------

|

||||

|

||||

- **单个基础类**

|

||||

|

||||

```

|

||||

class Base

|

||||

{

|

||||

private:

|

||||

int a;

|

||||

int b;

|

||||

public:

|

||||

void test();

|

||||

};

|

||||

```

|

||||

|

||||

内存分布:

|

||||

|

||||

```

|

||||

class Base size(8):

|

||||

+-- -

|

||||

0 | a

|

||||

4 | b

|

||||

+-- -

|

||||

```

|

||||

|

||||

**总结**:我们发现普通类的内存分布是根据声明的顺序进行的,成员函数不占用内存。

|

||||

|

||||

------

|

||||

|

||||

- **基础类+继承类**

|

||||

|

||||

```

|

||||

class Base

|

||||

{

|

||||

int a;

|

||||

int b;

|

||||

public:

|

||||

void test();

|

||||

};

|

||||

|

||||

class Divide :public Base

|

||||

{

|

||||

public:

|

||||

void run();

|

||||

private:

|

||||

int c;

|

||||

int d;

|

||||

};

|

||||

```

|

||||

|

||||

内存分布:

|

||||

|

||||

```

|

||||

class Divide size(16) :

|

||||

+-- -

|

||||

0 | +-- - (base class Base)

|

||||

0 | | a

|

||||

4 | | b

|

||||

| +-- -

|

||||

8 | c

|

||||

12 | d

|

||||

+-- -

|

||||

```

|

||||

|

||||

**总结**:根据内存分布,我们发现普通继承类,内存分布也是按照声明的顺序进行的,成员函数不占用内存;类的顺序是先基类,后子类。

|

||||

|

||||

------

|

||||

|

||||

- **含有虚函数的基类**

|

||||

|

||||

```

|

||||

class Base

|

||||

{

|

||||

int a;

|

||||

int b;

|

||||

public:

|

||||

void test();

|

||||

virtual void run();

|

||||

};

|

||||

```

|

||||

|

||||

内存分布:

|

||||

|

||||

```

|

||||

class Base size(12) :

|

||||

+-- -

|

||||

0 | {vfptr}

|

||||

4 | a

|

||||

8 | b

|

||||

+-- -

|

||||

|

||||

Base::$vftable@:

|

||||

| &Base_meta

|

||||

| 0

|

||||

0 | &Base::run

|

||||

```

|

||||

|

||||

**总结**:带有虚函数的内存分布分为两部分,一部分是内存分布,一部分是虚表;我们从最上面发现,`vfptr`是放在了内存开始处,然后才是成员变量;虚函数`run`前面表示这个虚函数的序号为`0`。

|

||||

|

||||

------

|

||||

|

||||

- **含有虚函数的基类+继承子类**

|

||||

|

||||

```

|

||||

class Base

|

||||

{

|

||||

int a;

|

||||

int b;

|

||||

public:

|

||||

void test();

|

||||

virtual void run();

|

||||

};

|

||||

|

||||

class Divide :public Base

|

||||

{

|

||||

public:

|

||||

void DivideFun();

|

||||

virtual void run();

|

||||

private:

|

||||

int c;

|

||||

int d;

|

||||

};

|

||||

```

|

||||

|

||||

内存分布:

|

||||

|

||||

```

|

||||

class Divide size(20) :

|

||||

+-- -

|

||||

0 | +-- - (base class Base)

|

||||

0 | | {vfptr}

|

||||

4 | | a

|

||||

8 | | b

|

||||

| +-- -

|

||||

12 | c

|

||||

16 | d

|

||||

+-- -

|

||||

|

||||

Divide::$vftable@:

|

||||

| &Divide_meta

|

||||

| 0

|

||||

0 | &Divide::run

|

||||

```

|

||||

|

||||

**总结**:我们发现继承类,虚表只有一个,还是在内存开始处,内存排布顺序与普通继承类是一致的;

|

||||

|

||||

------

|

||||

|

||||

- **含有虚函数的基类+继承子类(多增加一个虚函数)**

|

||||

|

||||

```

|

||||

class Base

|

||||

{

|

||||

int a;

|

||||

int b;

|

||||

public:

|

||||

void test();

|

||||

virtual void run();

|

||||

};

|

||||

|

||||

class Divide :public Base

|

||||

{

|

||||

public:

|

||||

void DivideFun();

|

||||

virtual void run();

|

||||

virtual void DivideRun();

|

||||

private:

|

||||

int c;

|

||||

int d;

|

||||

};

|

||||

```

|

||||

|

||||

内存分布:

|

||||

|

||||

```

|

||||

class Divide size(20) :

|

||||

+-- -

|

||||

0 | +-- - (base class Base)

|

||||

0 | | {vfptr}

|

||||

4 | | a

|

||||

8 | | b

|

||||

| +-- -

|

||||

12 | c

|

||||

16 | d

|

||||

+-- -

|

||||

|

||||

Divide::$vftable@:

|

||||

| &Divide_meta

|

||||

| 0

|

||||

0 | &Divide::run

|

||||

1 | &Divide::DivideRun

|

||||

```

|

||||

|

||||

**总结**:虚表还是继承于基类,在虚表部分多了`DivideRun`序号为`1`的虚函数;

|

||||

|

||||

------

|

||||

|

||||

- **多重继承**

|

||||

|

||||

```

|

||||

class Base

|

||||

{

|

||||

int a;

|

||||

int b;

|

||||

public:

|

||||

virtual void run();

|

||||

};

|

||||

|

||||

class Divide1 :public Base

|

||||

{

|

||||

public:

|

||||

virtual void run();

|

||||

private:

|

||||

int c;

|

||||

};

|

||||

|

||||

class Divide2 :public Base

|

||||

{

|

||||

public:

|

||||

virtual void run();

|

||||

private:

|

||||

int d;

|

||||

};

|

||||

|

||||

class Divide :public Divide1, Divide2

|

||||

{

|

||||

public:

|

||||

virtual void run();

|

||||

private:

|

||||

int d;

|

||||

};

|

||||

```

|

||||

|

||||

内存分布:

|

||||

|

||||

```

|

||||

class Divide1 size(16) :

|

||||

+-- -

|

||||

0 | +-- - (base class Base)

|

||||

0 | | {vfptr}

|

||||

4 | | a

|

||||

8 | | b

|

||||

| +-- -

|

||||

12 | c

|

||||

+-- -

|

||||

|

||||

Divide1::$vftable@:

|

||||

| &Divide1_meta

|

||||

| 0

|

||||

0 | &Divide1::run

|

||||

|

||||

Divide1::run this adjustor: 0

|

||||

|

||||

class Divide2 size(16) :

|

||||

+-- -

|

||||

0 | +-- - (base class Base)

|

||||

0 | | {vfptr}

|

||||

4 | | a

|

||||

8 | | b

|

||||

| +-- -

|

||||

12 | d

|

||||

+-- -

|

||||

|

||||

Divide2::$vftable@:

|

||||

| &Divide2_meta

|

||||

| 0

|

||||

0 | &Divide2::run

|

||||

|

||||

Divide2::run this adjustor: 0

|

||||

|

||||

class Divide size(36) :

|

||||

+-- -

|

||||

0 | +-- - (base class Divide1)

|

||||

0 | | +-- - (base class Base)

|

||||

0 | | | {vfptr}

|

||||

4 | | | a

|

||||

8 | | | b

|

||||

| | +-- -

|

||||

12 | | c

|

||||

| +-- -

|

||||

| +-- - (base class Divide2)

|

||||

| | +-- - (base class Base)

|

||||

| | | {vfptr}

|

||||

| | | a

|

||||

| | | b

|

||||

| | +-- -

|

||||

| | d

|

||||

| +-- -

|

||||

| d

|

||||

+-- -

|

||||

|

||||

Divide::$vftable@Divide1@:

|

||||

| &Divide_meta

|

||||

| 0

|

||||

0 | &Divide::run

|

||||

|

||||

Divide::$vftable@Divide2@:

|

||||

| -16

|

||||

0 | &thunk: this -= 16; goto Divide::run

|

||||

|

||||

Divide::run this adjustor: 0

|

||||

```

|

||||

|

||||

总结:主要看最后一个`Divide`类,内存排列顺序先是Divide1,后是Divide2,在Divide1和Divide2中各有一份虚表;

|

||||

|

||||

------

|

||||

|

||||

- **虚拟继承(菱形继承)**

|

||||

|

||||

```

|

||||

class Base

|

||||